03/09/2024 (2020-12-17)

[Source : Konfedera.org]

[Auteur : François Jortay]

Gestion des épidémies

Màj : 30 juil. 2020 – # pages : 64

1. Résumé 2. Introduction 2.1. Auteur 2.2. Objectif 2.3. Méthode 2.4. Conseils de lecture 3. Modèles mathématiques 3.1. Principes 3.2. Limites des modèles mathématiques 3.2.1. Stochasticité 3.2.2. Sensibilité 3.2.3. Irréductibilité 3.2.4. Réalité 3.3. Modèles et idéologies 3.3.1. Interprétations abusives 3.3.2. Neil Ferguson 4. Modèle SIR 4.1. Système d'équations 4.2. Hypothèses 4.3. Taux de reproduction 4.4. Immunité collective 4.5. Stratégies 4.6. Mortalité 4.7. Charge hospitalière 4.8. Valeur scientifique du "R zéro" 4.8.1. Le fumigène R0 4.8.2. Calcul du R0 4.8.3. Utilisations du R0 5. SIR et la grippe 6. SIR et covid-19 6.9. Paramétrage en début de confinement 6.10. Paramétrage en fin de confinement 6.11. Rebond de l'enfermement cognitif 6.12. Bilan 6.13. Typologie des facteurs d'inefficacité 7. Suivi en temps réel 7.1. Ressources 7.2. Définitions 7.3. Mesure 7.3.1. Taux d'infection 7.3.2. Taux de mortalité et létalité 8. Stratégies anti-épidémiques 8.1. Principes de gestion anti-épidémique 8.2. Immunité collective 8.3. Stratégie non pharmaceutique (SNP) 8.3.1. Principes 8.3.2. Efficacité de la SNP 8.3.3. Effets pervers de la SNP 8.3.4. Conclusion 8.4. Stratégie pharmaceutique (SP) 8.4.1. Traitements 8.4.2. Dépistage 8.5. Principe de précaution ? 8.6. Quelle stratégie appliquer ? 9. covid-19 : analyse d'un délire collectif 9.1. QUOI : Info vs réalité 9.1.1. Charge hospitalière 9.1.2. Mortalité toutes causes 9.1.3. Différences entre pays 9.2. Agents du délire collectifs 9.2.1. Entreprises "d'information" 9.2.2. Atlantisme anti-chinois 9.2.3. Scientifiques de plateau TV 9.2.4. Personnel médical 9.2.5. Gouvernements 10. Contexte économique 10.1. Concurrence chinoise 10.2. Big Data & Pharma Inc. 10.3. Extrémisme vert 11. Problématique politique 12. Conclusion

Résumé

https://konfedera.org/gestion-epidemies#resume

- La thèse que les entreprises « d’information » et certains scientifiques propagent concernant covid-19 est la suivante : covid-19 est un virus nouveau. Il en résulte que :

(i) il n’existe ni médicament spécifique ni vaccin ;

(ii) personne n’est immunisé (absence d’anticorps) ⇒ il n’existe pas de barrière physiologique à sa propagation, qui est alors rapide.

Par conséquent, pour éviter le risque de surcharge du système hospitalier, il faut imposer le confinement général des populations, ce qui aura pour effet de retarder et d’abaisser le sommet de la courbe épidémique. On gagnerait ainsi du temps pour augmenter la capacité hospitalière et développer des médicaments/vaccins spécifiques avant le pic épidémique. Ce raisonnement peut sembler imparable, et pourtant il est totalement erroné car :- une partie de la population est immunisée de naissance et/ou par immunité croisée (anticorps non-spécifiques);

- certains médicaments non spécifiques sont efficaces;

- il est n’est pas possible de développer les capacités hospitalières de façon substantielle et des médicaments/vaccins spécifiques réellement efficaces en moins de cinq ans. Ces mesures conduiraient en outre à maintenir une (très large) surcapacité hospitalière et à augmenter sans fin le nombre des médicaments et vaccins (on peut toujours considérer qu’un virus est « nouveau » dès que l’on découvre – grâce au progrès scientifique qui est sans fin – des « différences » par rapport aux autres membres de sa famille virale).

- pour freiner substantiellement la propagation d’un virus le coût des mesures à appliquer (confinement, distanciation, masques, lavages) est tellement élevé que même en milieu hospitalier – pourtant équipé de tout le matériel nécessaire et où les règles sanitaires sont strictement appliquées par des professionnels avec un haut niveau de formation – on n’arrive pas à neutraliser les infections nosocomiales ; certaines des mesures sanitaires sont en réalité appliquées pour des raisons juridiques et d’image de marque (la concurrence joue aussi dans le secteur hospitalier).

- Extinction. Les épidémies ont une évolution dont la courbe a la forme d’une cloche, ce qui signifie qu’au début elles montrent en général une croissance exponentielle. Or toutes les épidémies s’éteignent naturellement avant d’avoir contaminé 100% de la population. Et la plupart avant même d’avoir atteint le taux théorique d’immunité collective, pour des raisons encore inconnues mais très probablement liées au virus lui-même et/ou aux écosystèmes dans lesquels il évolue.

- Modèles. Le recours à des modèles mathématiques à des fins de suivi épidémique et de prévision est irrationnel car :

- dans le cas des virus « nouveaux », leur paramètres sont inconnus et ne peuvent être correctement évalués en temps réel (c-à-d en cours d’épidémie) en raison de biais de mesure ne pouvant être corrigés qu’au moins douze mois après le début de l’épidémie;

- quant aux virus en général, c-à-d connus ou non, leurs caractéristiques (les valeurs attribuées aux paramètres des modèles) ne sont pas stables dans le temps (voire même non plus dans l’espace), en raison de la nature écosystémique c-à-d complexe des phénomènes infectiologiques.On constate d’ailleurs une très forte propension de ces modèles (ou de leur paramétreurs ?) à produire des « prévisions » qui s’avèrent in fine de gigantesques surestimations du taux de mortalité des épidémies.

- Rebonds. Il suffit que le nombre de tests augmente (par exemple suite à la surmédiatisation de « prévisions » catastrophistes) pour qu’augmente le nombre d’infectés recensés. Il résulte de cet effet de recensement que la gestion épidémique ne doit surtout pas être pilotée en fonction de l’évolution du taux d’infection, mais en fonction du taux de mortalité (toutes causes !) par rapport à la population (PS : dans le cas où la hausse du nombre de tests est provoquée par l’annonce de « prévisions » catastrophistes l’effet de recensement induit donc un effet de prophétie auto-réalisatrice).

- Mortalité. En Europe, région du monde la plus touchée par covid-19, la mortalité toutes causes sur l’ensemble de l’année 2020 aurait probablement été la plus basse des quatre dernières années s’il n’y avait eu les décès attribués à covid-19, mais principalement causés par une mauvaise stratégie anti-épidémique.

- Causes. Les pouvoirs médiatique, académique et politique ne s’en sont jamais cachés : pour qu’un maximum de gens appliquent les mesures de la stratégie « non pharmaceutique » (SNP : confinement, distanciation, masques, lavages) il faut faire peur à la population. La SNP implique donc la terreur, or celle-ci induit de graves effets délétères :

- la panique, qui inhibe les capacités cognitives :

- des décideurs politiques : ainsi pour libérer des lits d’hôpitaux en prévision d’une prétendue « possible explosion » (sic) du nombre de malades sévères de la covid-19 il a été décidé d’isoler un maximum de vieillards dans les maisons de repos … qui ne disposent ni du matériel ni de personnel pour soigner les cas graves;

- des médecins hospitaliers : ainsi plus de 50% de la mortalité hospitalière attribuée à covid-19 serait causée par les intubations abusives.

- le stress psychique, qui inhibe le système immunitaire (NB : ces effets sont démultipliés par l’isolement qu’implique le confinement général);

- la peur de la contamination, qui inhibe la demande et l’offre de services médicaux.D’autre part des effet d’entraves ont encore accru la mortalité attribuée à covid-19 :

- une réglementation médicale pénalisant l’utilisation de médicaments « non spécifiques » même dans une situation « de crise » face à un virus « nouveau »;

- le confinement général entrave la production & distribution de biens et services indispensables à la lutte contre l’épidémie (médicaments, respirateurs, …).

- la panique, qui inhibe les capacités cognitives :

- Précaution. L’invocation du principe de précaution par les conseillers scientifiques de nombreux gouvernements pour « justifier » l’imposition de la stratégie préventive dite « non pharmaceutique » (SNP : confinement, distanciation, masques, lavages) est fallacieuse. En effet le principe de précaution ne consiste pas à appliquer une mesure incertaine sous prétexte qu’elle pourrait peut-être fonctionner, mais au contraire à ne pas appliquer une mesure sans être certain que ses effets pervers ne l’emportent pas sur ses supposés effets positifs.

- Dépistage. Le dépistage est utile mais très coûteux :

- en termes financiers ⇒ il doit être limité aux groupes à risque;

- en termes démocratiques ⇒ son éventuelle obligation doit faire l’objet d’un référendum (organisé en période non épidémique).

- Médias. Au cours des dernières décennies, comme de tout temps, des virus considérés comme « nouveaux » se sont répandus sur la quasi totalité de la planète (pandémie). Dans la plupart des cas on a également assisté à une hystérie collective, mais jamais avec une intensité telle que pour covid-19 (et en particulier on n’avait pas eu recours au confinement et masques généralisés c-à-d obligatoires). La perte d’audience des médias « d’information », suite à la concurrence d’Internet, pousse ces entreprises à toujours plus de catastrophisme afin de booster l’audimat. Pour ce faire elles n’ont aucune peine à trouver des scientifiques prêts à cautionner le catastrophisme afin de briller sous les spotlights des plateaux TV, ou encore des médecins hospitaliers pour qui le catastrophisme est l’occasion de revendiquer plus de financement public.

- Big pharma. Des articles scientifiques sérieux qui réfutent la vision catastrophiste de la situation sont censurés tandis que des articles d’une médiocrité manifeste sont publiés par les revues scientifiques les plus reconnues (prévisions catastrophistes, prétendue absence de traitement, prétendue efficacité de la SNP, …). Cela n’est certainement pas étranger au fait que de nombreux médecins chercheurs sont intoxiqués par des sources d’informations « scientifiques » produites par l’industrie pharmaceutique, et souvent ont carrément des conflits d’intérêt avec celle-ci.

- Surfeurs. Des forces économiques ont pu « surfer » sur la vague médiatique, et ainsi l’amplifier, en considérant que le coût économique de quelques mois de confinement général est très inférieur aux gains récurrents d’un changement de paradigme économique permis par le choc émotionnel :

- le potentiel financier et politique du « Big data » est tel (il concerne la quasi totalité des secteurs économiques) que de très fortes pressions ont pu être exercées sur les décideurs politiques afin que ceux-ci exploitent la vague médiatique catastrophiste pour amener les populations à accepter le traçage de leur vie privée;

- alors que jusqu’au début des années 2000 le libre-échange international était la pierre angulaire de l’idéologie atlantiste, on assiste à un rétro-pédalage intégral de la part des pays atlantistes depuis que cette logique se retourne contre eux (concurrence de la Chine) ⇒ la théorie du « nouveau risque épidémique » est l’occasion de « justifier » ce revirement idéologique.

- Démocratie. Étant donné que l’on découvre régulièrement de « nouveaux » virus en raison du développement des techniques de détection, il en résulte logiquement que si les populations ne se révoltent pas contre le confinement général et le traçage de nos relations, ces pratiques irrationnelles deviendront la norme. Prenons garde que ne s’installe un peu partout sur la planète des régimes qui, au nom de « la protection d’autrui », justifieraient notamment le traçage des individus, les vaccins obligatoires et la répression de la contestation.

- Responsabilités. Dans le délire collectif autour de covid-19 il y a une immense responsabilité des entreprises « d’information » ainsi que des scientifiques qu’elles médiatisent. D’autre part de nombreux scientifiques conscients de la supercherie ont fait preuve de suivisme en se taisant (ce qui n’est pas sans rappeler la coupable passivité de l’élite allemande lors de la montée en puissance du nazisme durant les années 1930).

- Réaction. Des délires tels que celui de 2020 se reproduiront s’il n’y a pas de prise de conscience :

- au niveau individuel : de la nuisibilité de l’info-dépendance;

- au niveau collectif : de la nécessité d’une prise de contrôle démocratique des moyens de production de l’information et du savoir.

Partagez cette étude en copiant/collant son adresse sur les réseaux sociaux ou dans un email :

https://konfedera.org/gestion-epidemies

et en ajoutant le texte de présentation :

Étude sur l’exploitation médiatique, commerciale ou politique de la peur, et sur l’avènement d’un totalitarisme « sanitaire ».

Agissez également dans le monde réel : marquez une barre verticale sur votre masque pour dénoncer l’avènement du totalitarisme « sanitaire ». P.S. Pourquoi une barre verticale : (1) facile à tracer sur les masques en accordéon ; (2) symbolise un citoyen debout, qui ne se couche pas devant l’exploitation de la peur. Ne portez le masque que là où c’est obligatoire.

Introduction

https://konfedera.org/gestion-epidemies#intro

Auteur

https://konfedera.org/gestion-epidemies#auteur

Je suis économiste de formation. En tant que chercheur libre, mon approche est fondée sur la transdisciplinarité c-à-d la spécialisation du chercheur dans la pluridisciplinarité – à ne pas confondre avec l’interdisciplinarité, qui est la collaboration de spécialistes dans des thématiques multidisciplinaires. Cette approche est certes ambitieuse voire prétentieuse, mais le lecteur pourra constater son énorme potentiel analytique, confirmé par la montée du présent article – sans équivalent dans son approche transdisciplinaire – dans la plupart des moteurs de recherche (Google, Bing, Yahoo, Qwant, DuckDuckGo, …), sur la thématique de gestion des épidémies.

J’attire enfin l’attention du lecteur sur un fait important : ayant banni la TV de mon domicile depuis l’année 2000, je ne suis pas info-dépendant.

Pour plus d’information sur mes domaines d’activité voir la page d’accueil de mon site portail jortay.net.

Objectif

https://konfedera.org/gestion-epidemies#objectif

En Chine, où l’épidémie est terminée, le taux de mortalité morts / population est de seulement 0,03 % pour l’agglomération de Wuhan (le foyer de l’épidémie, 11 millions d’habitants) et 0,0002 % pour l’ensemble de la Chine (1,386 milliard d’habitants) [source]. On comparera utilement ce dernier taux avec le taux correspondant de la grippe en France, soit 0,02 % [source].Taux de mortalité morts / population (%)

| covid-19 (Chine) | Grippe (France) | covid-19 / Grippe |

|---|---|---|

| 0,03 (Wuhan) | 0,02 | 1,5 |

| 0,0002 (Chine) | 0,01 |

Nomenclature : covid-19 est le nom de la maladie (« COronaVirus Disease 2019« ) tandis que SARS-CoV-2 est celui du virus (« Severe Acute Respiratory Syndrome COronaVirus 2« ) [source].

Nous verrons dans la section consacrée à l’analyse du catastrophisme médiatique que le gouvernement chinois a imposé le confinement général – NB : dans la seule région de Wuhan (le foyer épidémique) – pour des raisons de politique intérieure et extérieure. Il ne pouvait s’agir de raisons médicales car il n’existe, à notre connaissance, aucune étude scientifique sérieuse ni aucun manuel d’épidémiologie recommandant l’application du confinement général pour neutraliser une épidémie. Le tableau ci-dessus montre ainsi que le confinement général (i) n’a pu empêcher la propagation du virus dans le reste de la Chine, et (ii) que le taux de mortalité y est (très) inférieur alors que le confinement général n’y a pas été appliqué. Il y a donc une forte probabilité qu’une partie considérable du surplus de mortalité dans la région de Wuhan fut causée par les effets pervers du confinement général. Nous verrons qu’il existe de nombreux et solides arguments confirmant cette thèse.

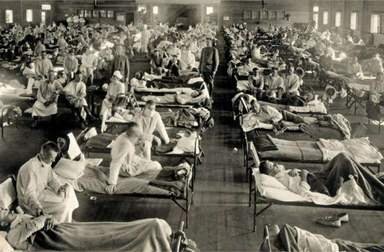

Régulièrement des continents sont confrontés à des pandémies d’agents infectieux nouveaux (grippes aviaires, H1N1, SARS, MERS, Ebola, chikungunya, Zika, …), causant des morts, et dont la croissance est exponentielle. À chaque fois il existe un risque plus ou moins élevé que le système hospitalier soit surchargé. À chaque fois les médias d’information ont suscité une atmosphère de panique. Mais jamais on avait atteint un état d’hystérie et de délire collectif tel qu’avec covid-19. En particulier jamais on avait appliqué le confinement général.

Pourquoi alors la stratégie préventive dite « non pharmaceutique (SNP : confinement, distanciation, masques, lavages) a-t-elle été appliquée lors de l’épidémie de covid-19 en 2020 alors qu’il n’existe pas de critère objectif permettant de déterminer un niveau de risque de mortalité au-delà duquel il faudrait appliquer la stratégie SNP, et en-dessous duquel cela ne serait pas nécessaire.

Il importe de trouver la réponse à cette question car la similitude du phénomène covid-19 avec la guerre (la vraie), cette autre folie collective, est flagrante. Or en situation de guerre, il n’y a plus de place pour le débat : si vous critiquez le gouvernement, celui-ci et ceux qu’il a rallié à lui grâce à la panique, vous accusent de jouer le jeu de l’ennemi meurtrier. Cette vision réductrice a pour effet d’inhiber (voir criminaliser) le débat public et partant l’intelligence collective. Cela conduit à l’incapacité collective de s’adapter intelligemment à l’évolution de la situation et des informations disponibles. Il en résulte généralement des catastrophes. Ainsi en cédant à la panique on peut perdre une guerre face à un ennemi même insignifiant (prophétie autoréalisatrice).

Pour ce faire la suite du présent article est composée de dix parties :

• Modèles mathématique

• Modèle SIR

• SIR et la grippe

• SIR et covid-19

• Suivi en temps réel

• Stratégie anti-épidémiques

• covid-19 : analyse d’un délire collectif

• Contexte économique

• Problématique politique

• Conclusion

Méthode

https://konfedera.org/gestion-epidemies#methode

Cette étude est une publication en édition continue (commencée début mars 2020) : elle fait quotidiennement l’objet de plusieurs mises à jour (corrections, ajouts, structuration, …) ⇒ le lecteur qui souhaite améliorer sa compréhension de la problématique et la mettre à jour (NB : auprès d’un chercheur non info-dépendant) est invité à relire cette étude tous les trois mois.

Les sources sont toutes scientifiques. Quelques articles de presse sont cités, soit parce qu’il s’agit d’interviews ou cartes blanches de scientifiques, soit pour montrer que si les entreprises « d’information » ont besoin de se fabriquer un capital confiance c’est aussi pour le consommer – c-à-d conditionner l’opinion publique – lorsqu’elles en reçoivent instruction.

Les sources sont systématiquement mentionnées par lien hypertexte, ce qui fait de cette étude, via son sommaire, une base de données très pratique sur les thématiques de la gestion épidémique en général et de covid-19 en particulier.

Conseils de lecture

https://konfedera.org/gestion-epidemies#conseils-de-lecture

Vous sentez que quelque chose de puissant, grave et potentiellement durable est en train de se produire, qui dépasse largement le cadre de cette « pandémie meurtrière ». Mais vous vous sentez également impuissant(e), ce qui augmente votre anxiété. La solution est de réagir par une action inscrite dans le long terme : « un petit peu, mais chaque jour« . Un petit peu de quoi ? Et bien, pour commencer, d’étude ! Le reste viendra naturellement, via les liens que vous allez ainsi construire … et qui seront autant d’opportunités pour le futur de votre parcours de vie (NB : les plus grandes crises sont des occasions de « saut évolutionniste » … pour qui ne reste pas dans la passivité).

La compréhension du présent document est accessible par quiconque a terminé ses études secondaires. Cependant il est relativement long (plus de 60 pages) et son abord est parfois ardu. Cela est inévitable en raison de la sophistication des forces en action. Ce travail ne se lit donc pas en une fois mais un petit peu chaque jour (par exemple donnez-vous une semaine ou un mois pour le lire). Si certains passages vous paraissent difficiles lisez-les malgré tout, puis passez à la suite. Cela vous permettra d’avoir une vue d’ensemble lors de l’indispensable seconde lecture.

Lors de la première lecture évitez, autant que faire se peut, de cliquer sur les (nombreux) liens, sinon vous allez vous noyer. Ne consultez éventuellement les liens que lors de la seconde lecture.

Enfin, avant de vous lancer, je vous invite à lire d’ors et déjà cet extrait d’un autre article, concernant l’info-dépendance, phénomène dont vous êtes probablement victime …

Modèles mathématiques

https://konfedera.org/gestion-epidemies#modeles-mathematiques

Dans cette section nous allons exposer les principes de base de la modélisation mathématique. Ensuite nous en énoncerons les limites. Enfin nous illustrerons l’influence (très sous-estimée) de l’idéologie sur l’utilisation des modèles mathématiques.

Principes

https://konfedera.org/gestion-epidemies#modeles-mathematiques-principes

La modélisation mathématique d’un phénomène naturel permet au moins trois types d’utilisation :

- explication : faciliter l’étude de ce phénomène (enseignement & recherche) en reproduisant sont fonctionnement par une simulation simplifiée (en laboratoire ou sur ordinateur);

- prévision : prédire son évolution future … mais cela n’est possible que pour les phénomènes dont la valeur des paramètres est stable dans le temps ainsi que dans l’espace considéré (notion de référentiel);Cette stabilité des paramètres est vérifiée dans le cas de phénomènes tels que la chute d’un corps, mais nous verrons que ce n’est pas le cas des phénomènes épidémiques autres que in vitro.

- exploitation : élaborer des techniques pour exploiter ou au contraire neutraliser ce phénomène.

Corrélation. Ainsi le modèle M ≡ y = a * x + b décrit une relation (linéaire) entre des variables x et y, les grandeurs a et b étant considérées (à tort ou à raison) comme constantes et par conséquent qualifiées de « paramètres ».

Mesure vs calcul. En présentant le modèle comme ci-dessus plutôt que, par exemple, comme M ≡ a * x + b * y = c on suggère que x est la variable d’entrée (input) et que y est la variable de sortie (output), c-à-d que x est mesurée, tandis que y est calculée. NB : cela n’implique pas nécessairement une causalité entre les deux, mais peut se justifier par exemple parce qu’il est moins coûteux de calculer y que de le mesurer.

Causalité. Tel que formulé ci-dessus, c-à-d sans indices de temps, le modèle ne dit rien quant à une éventuelle causalité soit de x sur y, ou inversement, ou les deux (boucle de rétroaction), ou/et d’une ou plusieurs variables non représentées dans le modèle. Du point de vue physique l’effet d’une relation causale ne peut être instantanée, sauf à supposer qu’un corps peut se déplacer, du lieu de la cause à celui de l’effet, à une vitesse infinie c-à-d supérieure à celle de la lumière, ce qui dans l’état actuel de la science physique est généralement considéré comme impossible. La cause doit donc nécessairement précéder temporellement son effet. Par conséquent une causalité de x sur y devrait être formulée par : yt+k = a * xt + b où k est le temps écoulé entre une variation de x et son effet sur y.

Calcul descriptif ou prédictif. On pourra alors tirer les conclusions suivantes sur les possibilités d’utilisations du modèle M ≡ y = a * x + b :

- si relation asynchrone yt+k = a * xt + b ⇒ au temps t=0 je peux prédire yk si j’ai la possibilité de mesurer x0;

- si relation synchrone yt = a * xt + b ⇒ au temps t=0 :

- je peux calculer y0 après avoir mesuré x0 (/ ou inversement), ce qui est généralement moins coûteux que de mesurer y0 (/ ou x0) ; mais il s’agit d’un calcul descriptif et non pas prédictif ;

- il m’est impossible de prédire ni xt ni yt car pour cela je devrais connaître la valeur de leur(s) éventuelle(s) variable(s) déterminante(s) (on dit aussi « explicatives« ) en t=0, or le modèle M ≡ yt = a * xt + b ne contient pas les équations exprimant leurs relations avec xt et yt (soit parce que le phénomène est stochastique soit parce que le modèle est incomplet).

La valeur calculée y0 (descriptive) ou yk (prédictive) sera d’autant moins proche de sa valeur réelle que les erreurs de mesure de x0, a et b seront élevées, et que la valeur de chacun de ces deux paramètres a et b ne sera pas constante (ou suffisamment peu variable, puisque dans le monde réel les véritables constantes sont relativement rares).

Dimensions temporelle et spatiale

Les notions de variables et constantes concernent les dimensions temporelle et spatiale : une grandeur change (variable) ou pas (constante) :

- avec le temps qui passe ⇒ dimension temporelle ;

- selon le lieu (et donc l’individu) ⇒ dimension spatiale.

À noter que le temps est de dimension 1 (une droite) et ne peut évoluer que dans le sens positif (on ne peut reculer dans le temps), tandis que l’espace est de dimension 3 (voire plus) et un corps peut s’y déplacer dans les deux sens positif (avancer) et négatif (reculer) d’une droite, ainsi que dans toutes ses directions. D’autre part le temps passe inexorablement tandis qu’un corps peut être soit à l’arrêt soit en mouvement.

Modèle épidémiologique SIR

Un modèle est donc nécessairement une représentation simplifiée de la réalité. Il y a là une rationalité économique : on veut pouvoir reproduire (simuler) un phénomène au moyen d’un système le plus simple possible (petit nombre de variables et paramètres, relations linéaires, …). Cela ne veut pas dire qu’il n’est pas possible de simuler un phénomène complexe (grand nombre de variables et paramètres, relations non linéaires, effets de rétroactions, …), c’est même dans ce cas qu’un modèle programmé dans un ordinateur permet de dépasser les limites de l’intuition humaine. Il serait donc injuste d’assimiler ces modèles à l’allégorie de la caverne.

Il importe cependant de faire preuve de prudence dans les modes d’application et l’interprétation des modèles. La relative facilité à les concevoir et « faire tourner » peut rapidement conduire au fétichisme du jouet mathématique voire à un enfermement cognitif (tels qu’observés chez de nombreux adeptes des modèles astrologiques), consistant notamment à croire que la modélisation mathématique constitue la démonstration d’une thèse alors qu’elle n’en est que la formulation.

Ainsi en économie et épidémiologie les modèles mathématiques doivent être constamment reparamétrés (la valeur des paramètres doit être réévaluée) pour qu’ils puissent simplement reproduire les phénomènes observés. L’instabilité temporelle (voire même spatiale) des paramètres – due à la nature écosystémique des phénomènes économiques et épidémiologiques – induit l’impossibilité pour ces modèles de prédire le développement futur de ces phénomènes. Dans ce dernier domaine la mutabilité des virus ou bactéries (qui en font de nouveaux objets biologiques dont les propriétés sont alors supposées inconnues) ne fait qu’accroître cette incertitude.

Limites des modèles mathématiques

https://konfedera.org/gestion-epidemies#limites-modeles-mathematiques

Neil Ferguson, le physicien converti à l’épidémiologie qui en 2020 a réussi à convaincre de nombreux gouvernements que l’épidémie de covid-19 allait provoquer au moins 55 millions de morts si l’on appliquait pas le confinement général, est pourtant connu pour ses prévisions aussi catastrophistes … qu’erronées [source] :

- en 2005 il prédit que la grippe aviaire tuerait 200 millions de personnes : il y eu quelques centaines de victime;

- en 2009, il prédit que la grippe porcine tuerait 65.000 Britanniques : il y eu moins de cinq cents victimes;

Dans aucun de ces deux cas, le confinement général n’a été appliqué. Heureusement car sinon les adeptes des modèles épidémiologiques auraient affirmé que la catastrophe a été évitée grâce au confinement général. En 2020, ce fut malheureusement différent …

L’incapacité d’un modèle à simplement reproduire un phénomène (par simulation dans un laboratoire ou sur un ordinateur) autrement qu’en adaptant la valeur des paramètres, implique l’impossibilité de prédiction par ce modèle.

D’autre part l’incapacité de reproduction systématique (c-à-d sans devoir adapter la valeur des paramètres) peut avoir trois types de causes :

- phénomène est stochastique (c-à-d soumis au hasard) ⇔ les paramètres du modèles sont variables dans le temps et l’espace.

- le phénomène est déterministe (c-à-d non soumis au hasard) mais :

- sensible aux conditions initiales;

- ou bien la mesure des valeurs d’entrées (et des paramètres en cas d’instance nouvelle) ne peut être réalisée correctement qu’après la fin du phénomène (cette cause sera développée dans la section consacrée aux limites des modèles épidémiologiques);

- ou bien le modèle est incomplet (réductionnisme voire irréductibilité).

Stochasticité

Un phénomène stochastique (c-à-d soumis au hasard) ne peut-être reproduit qu’en adaptant à chaque fois la valeur des paramètres du modèle puisque ceux-ci sont par nature variables dans le temps et l’espace. Par conséquent il est impossible de prédire l’évolution d’un phénomène stochastique.

Avec le développement des capacités de traitement des donnés (quantité et vitesse) sont apparus des modèles dits « stochastiques« . Ils concernent des quantités « macroscopiques » vues comme des moyennes statistiques de quantités microscopiques (par exemple la pression et la température d’un volume gazeux). Le principe est ici que l’instabilité exponentielle du système « microscopique », c-à-d l’imprévisibilité des variables du niveau micro, n’impliquerait pas l’imprévisibilité de moyennes statistiques au niveau macro. Il existe cependant des situations particulières dites « critiques » où l’on observe un phénomène de « transition de phase » c-à-d tel que le système « hésite » de façon imprévisible et changeante entre deux chemins possibles [source].

Sensibilité

Les scientifiques avaient l’habitude de penser que si l’on pouvait isoler un système des influences de son environnement et le décrire à l’aide d’un nombre réduit de variables, il serait à la fois déterministe et prévisible. Mais on sait aujourd’hui que pour être prévisible, un système doit être déterministe et stable : de petites incertitudes sur l’état initial du système ne doivent pas s’amplifier trop vite, sinon toute prédiction sur le comportement futur du système devient illusoire [source]. Des systèmes déterministes, c-à-d dont l’état futur est complètement déterminé par leur état présent, peuvent donc être imprévisibles. Et cela n’a rien à voir avec la complexité : ce phénomène de sensibilité aux conditions initiales concerne également les systèmes simples (petit nombre de variables, relations linéaires, …).

Sensibilité aux conditions initiales

Dans cette animation en boucles (30 sec.), après quelques secondes les deux pendules se désynchronisent brusquement [source].

Un système est dit chaotique si une infime perturbation de son état initial peut bouleverser entièrement son évolution. Un système chaotique n’est pas nécessairement complexe.

Irréductibilité

Les modèles mathématiques reposent sur un certain nombre d’hypothèses – notamment la formulation des relations entre variables (les équations), la valeur des paramètres (les supposées « constantes » de ces équations) et conditions initiales – supposées représenter la réalité.

Voici quelques hypothèses sur les modes de transmission du virus covid-19, tirées de l’article de Neil Ferguson [source], sur base duquel de nombreux gouvernements ont décidé d’appliquer la distanciation sociale (confinement et masque généralisés) lors de l’épidémie de 2020 :

- « 30% des hospitalisés le seront en soins intensifs, et 50% de ceux-ci meurent » ;

- « le nombre de contacts par individu dans les écoles est le double de celui observé ailleurs » ;

- « la période d’incubation est de 5,2 jours » ;

- « l’infectiosité survient 12 heures avant le début des symptômes pour les symptomatiques, et 4,6 jours après l’infection pour les asymptomatiques » ;

- « le taux de propagation R0=2,4 » ;

- « les symptomatiques sont 50% plus contaminants que les asymptomatiques » ;

- « deux tiers des symptomatiques le sont suffisamment pour s’auto-confiner dans les 24 heures suivant l’apparition des symptômes, et sont hospitalisés dans les cinq jours » ;

- « la durée d’hospitalisation est de 8 jours pour les cas non critiques et 16 jours pour les cas critiques » ;

- « 70% des ménages respectent les mesures sanitaires » ;

- « le taux de contact sur le lieu de travail est diminué de 25% (distanciation) » ; …

Dans la section #modeles-mathematiques-principes nous avons vu que l’intérêt des modèles réside précisément dans leur simplicité. Mais lorsqu’un phénomène est difficilement modélisable et que par conséquent les modèles n’arrivent pas à simplement reproduire correctement ses instances (ce qui implique évidemment l’incapacité de prédire celles-ci) des scientifiques qui ont investi leur carrière dans cette voie peuvent être tenté, plutôt que de changer de domaine de recherche, de s’obstiner en augmentant sans fin le nombre des variables, paramètres et équations (ce qui est le cas des modèles dérivés de SIR). Il en résulte des modèles complexes qui non seulement ne sont pas plus performants mais qui en outre sont beaucoup plus difficiles à comprendre, de sorte qu’ils n’ont plus aucun intérêt (notamment pour l’enseignement). C’est le cas notamment en économie et épidémiologie/infectiologie, qui semblent bien être des phénomènes irréductibles.

L’incapacité prédictive des modèle épidémiologiques (sauf effet du hasard) n’est pas étonnante car la dynamique des maladies transmissibles est extrêmement complexe. On observe ainsi une grande diversité dans la nature et la puissance des vecteurs : tous ne transmettent pas la maladie de la même manière, certains individus étant plus contaminants mais moins malades (par exemple les enfants) tandis que d’autres sont plus sensibles mais moins contaminants (par exemples les personnes âgées).

D’autre part les comportements culturels, comme cracher par terre et consommer peu ou beaucoup de certains aliments, peuvent induire des différences dans la propagation et la létalité d’un virus. Les maladies infectieuses sont donc des maladies d’écosystème. Par conséquent même si un modèle fonctionnait bien pour tel pays il pourrait ne pas fonctionner du tout pour d’autres pays. À cette variabilité spatiale s’ajoute une variabilité temporelle : les écosystèmes sont par nature changeant d’une année à l’autre (cf. la grippe qui chaque année peut changer de nature au niveau de sa virulence ou/et ténacité).

Didier Raoult – premier expert mondial dans le domaine des maladies transmissibles selon le classement expertscape – dénonce « une façon de transformer en mathématiques des phénomènes extrêmement complexes qui n’est jamais lucide » [source]. Il y a une incapacité des modèles mathématiques à représenter la complexité des maladies transmissibles, qui plus est dans le cas de virus nouveaux et/ou à mutations fréquentes. Aucun modèle ne peut prendre en compte toute l’hétérogénéité spatiotemporelle d’un contexte écoépidémiologique, ni même le degré de transmissibilité ou la vulnérabilité à une infection. On notera ainsi le gigantesque réductionnisme consistant à ramener à la seule problématique de propagation d’un virus celle, beaucoup plus complexe, de neutralisation de ses effets sur la santé publique.

Réalité

L’incapacité éventuelle d’un modèle mathématique à représenter un phénomène naturel n’est pas nécessairement liée à la conception (erronée ou incomplète) du modèle, mais peut aussi s’expliquer par l’inexistence du phénomène modélisé. Par exemple est-il certain que les notions « d’incidence épidémique d’un virus », de « maladie virale » ou encore de « taux de mortalité d’une maladie », correspondent à une quelconque réalité ? Ainsi lorsque nous pensons mesurer la durée moyenne d’une maladie virale nous ne mesurons en fait que des indicateurs dont nous supposons qu’il permettent de mesurer le début et la fin d’un concept que nous appelons « maladie virale ».

Ainsi la notion de « réalité » est liée à celles de « définition » et de « complexité » : pour comprendre la complexité du monde, c-à-d pouvoir agir sur lui ou par rapport à lui, nous en définissons des objets, dont nous mesurons les valeurs. Ce faisant nous pouvons éventuellement ouvrir des portes sur des applications (R&D), mais peut-être aussi nous éloignons-nous d’autres voies plus intéressantes (enfermement cognitif).

Modèles et idéologies

https://konfedera.org/gestion-epidemies#modeles-et-idéologies

Les modèles mathématiques ne sont pas seulement soumis à des contraintes logiques et physiques. Ils sont aussi l’objet d’utilisations abusives, fruits de leur incompréhension ou de motivations non scientifiques (idéologiques, financières, égotiques, …).

Interprétations abusives

https://konfedera.org/gestion-epidemies#interpretations-abusives

Illustrer vs

démontrer

Comprenons bien que les résultats d’un modèle mathématique ne constituent aucunement une démonstration (c-à-d une preuve) de la thèse modélisée ! Un modèle mathématique ne fait rien d’autre que de produire des valeurs (les « résultats du modèle ») correspondant à différentes valeurs de ses paramètres. Un modèle permet seulement d’illustrer différents scénarios d’une thèse (par exemple : « le confinement général permet de retarder et abaisser le sommet de la courbe épidémique« ), mais cela ne démontre pas cette thèse (ainsi il est certes incontestable que les modèles astrologiques produisent des prévisions, mais cela ne prouve en rien que ces modèles sont effectivement capables de prédire l’avenir).

La plupart des journalistes, décideurs politiques et même des scientifiques tombent dans le piège de cette confusion. C’est alors que peut entrer en jeu la manipulation des paramètres.

Valeurs des

paramètres

Nous avons vu que les résultats d’un modèle sont des scénarios correspondant à différentes valeurs des paramètres. Ces paramètres sont déterminés par les utilisateurs du modèle, mais sont généralement entachés de deux types de biais :

- estimations erronées : les valeurs initiales, les variables d’entrées et les paramètres peuvent être :

- mesurées sur l’épidémie en cours ; ⇒ ces valeurs sont d’autant moins pertinentes que les biais de mesures seront importants (cf. infra la section « #suivi-temps-reel« );

- mesurées sur de précédentes épidémies considérées comme « potentiellement similaires » ⇒ ces valeurs sont d’autant moins pertinentes que l’épidémie en cours est différente des celles utilisées comme référentiels ;

- calculées à partir d’autres modèles ⇒ ces modèles ne sont plus alors que des objets divinatoires.

- intérêts financiers/politiques/égotiques : ce dernier biais ne doit pas être sous-estimé : on peut faire dire beaucoup de chose (ce que l’on veut ?) à un modèle ; or des résultats catastrophistes augmentent les chances de médiatisation d’un modèle, et donc de ses auteurs …

On passe alors au stade suivant de la confusion voire manipulation : faire passer une valeur calculée pour une valeur observée.

Mesure

vs calcul

Les modèles peuvent être utilisés comme instrument d’analyse descriptive, par exemple pour calculer une valeur (estimation) lorsque sa mesure n’est pas disponible ou trop coûteuse. Il n’y a là rien d’abusif, sauf si on ne le mentionne pas. Or la plupart des articles de presse mélangent sans distinction des données mesurées et des données calculées (donc provenant de modèles), ce qui a pour effet que des valeurs calculées (qui peuvent être très éloignées de la réalité) sont présentées comme valeurs mesurées.

Enfin en toile de fond de ces confusions voire manipulation, il y a la question fondamentale de la causalité.

Corrélation

vs causalité

Une autre pratique abusive est d’interpréter une simple corrélation entre deux variables comme étant une relation de causalité selon laquelle l’une déterminerait l’autre. Exemple : « la vitesse de croissance de l’épidémie a diminué peu après l’implémentation du confinement général », alors que vitesse diminue toujours après une première phase exponentielle.

Conclusion. Quelques lignes extraites d’une étude scientifique [source], et qui nous rappellent que les modèles doivent être interprétés avec prudence et sens critique :

- « Certaines études antérieures ont signalé différente valeurs de R0 (de 1,40 à 6,49 avec une moyenne de 3,28) en raison de différentes sources de données, périodes et méthodes statistiques » (p. 16).

- « (…) nous avons fixé les valeurs de plusieurs paramètres sur la base d’études épidémiologiques antérieures sans tenir compte de l’incertitude, ce qui pourrait réduire la précision de nos résultats » (p. 17).

- « L’impact des interventions doit être considéré dans son ensemble et nous n’avons pas pu évaluer les stratégies individuelles par la courbe épidémique » (p. 17).

Neil Ferguson

https://konfedera.org/gestion-epidemies#Neil-Ferguson

Le graphique hyper-catastrophiste ci-dessous est le résultat d’une modélisation mathématique réalisée par le physicien anglais Neil Ferguson de l’Imperial College London. Selon ce graphique – publié le 16 mars 2020 c-à-d au début de l’épidémie de covid-19 en Europe – les malades sévères de covid-19 (c-à-d qui nécessiteront une hospitalisation) représenteront près de 300 fois les capacités hospitalières (30.000 % !) en l’absence de confinement général …

Une modélisation catastrophiste de covid-19

Ligne rouge : capacité hospitalière en lits de soins intensifs. Courbes : différents scénarios d’utilisation de la capacité selon la stratégie appliquée. Conclusion : dans tous les cas la capacité hospitalière serait submergée … [source]. Voir aussi cette interface de simulation.

Lysensko du

néolibéralisme

Étant donné qu’augmenter les capacités hospitalières dans de telles proportions est quasiment impossible à court et même moyen terme (et cela sans parler de la faisabilité politique et économique d’une surcapacité permanente en dehors des périodes d’épidémies) ces « prévisions » permettent de « justifier » les politiques néolibérales de santé : le recours récurrent au confinement général permettrait d’abaisser le niveau requis de capacité hospitalière ! Le caractère délirant de ces prévisions et de la politique de santé qu’elles impliquent a valu à Ferguson le sobriquet de « Lysenko du néolibéralisme« .

Rappelez-vous : au début de l’épidémie le message officiel était que le confinement permettrait de reculer le sommet épidémique et de nous donner ainsi du temps pour augmenter la capacité hospitalière. Or absolument aucun programme de développement de la capacité hospitalière n’a été mis sur pied, ni aucune entreprise publique de fabrication de masques et de respirateurs n’a été créée. Pourtant l’on nous assure que l’épidémie pourrait durer des années et que le pire pourrait être à venir. Il n’y a plus aucune connexion entre les discours médiatiques et la réalité.

Expert en

catastrophisme

Ferguson, qui s’est fait connaître grâce à ses prévisions catastrophistes, a bien compris que ce qui compte le plus ce n’est pas la valeur scientifique mais médiatique des prévisions épidémiques [source] : plus il exagère plus il gagne en notoriété publique, et plus ils obtient des contrats en tant qu’expert, notamment auprès de l’OMS, la Banque mondiale, l’Union européenne et de nombreux gouvernements [source]. Ferguson est devenu un véritable business man du catastrophisme épidémique. En 2008 il fonda le MRC Centre for Global Infectious Disease qui reçut plusieurs dizaines de millions de dollars de la Bill & Melinda Gates Foundation [source].

Ferguson fait évidemment des émules. Et en 2020 il prédit avec l’états-unien Anthony Fauci que Covid-19 devrait tuer au moins 55 millions d’humains dans le monde ! Le nombre final est de 540.000 soit cent fois moins. Et il s’agit là d’une estimation (début juillet 2020) qui sera certainement fortement revue à la baisse lorsque l’on obtiendra les statistiques mondiales de mortalité toutes causes permettant de prendre en compte les morts avec covid-19 enregistrés comme mort par covid-19. Il conviendra également de déterminer la part les décès causés par les effets pervers du confinement général et du climat de terreur qu’il a suscité.

Car cette fois Ferguson a réussi à convaincre de nombreux gouvernements, qui ont imposé le confinement général malgré le scepticisme de nombreux scientifiques, comme en témoigne ces extraits révélateurs d’un article du journal Le Monde du 15 mars 2020, concernant l’influence de Ferguson sur la stratégie du gouvernement Français pour gérer la crise covid-19 [source] :

- « Cette projection évalue le scénario le plus sombre, avec les hypothèses de mortalité les plus élevées et en l’absence de mesures radicales de prévention. »;

- « Selon ces modélisations confidentielles, dont Le Monde a eu connaissance, l’épidémie de Covid-19 pourrait provoquer en France, en l’absence de toute mesure de prévention ou d’endiguement, de 300 000 à 500 000 morts. »;

- « Précision extrêmement importante : ce scénario a été calculé en retenant les hypothèses de transmissibilité et de mortalité probables les plus élevées, et ce en l’absence des mesures radicales de prévention et d’éloignement social qui viennent d’être prises »;

- « Les résultats pour la France ont été présentés jeudi 12 mars à l’Elysée. Quelques heures avant que le président ne prenne solennellement la parole devant les Français pour expliquer « l’urgence » de la situation. »;

- « Il existe des incertitudes quant aux hypothèses retenues et au comportement du virus – pourcentage d’asymptomatiques, transmissibilité, impact des mesures de quarantaine »;

- « différentes modélisations ont été présentées jeudi matin puis jeudi après-midi à Emmanuel Macron par le conseil scientifique, mais qu’il n’existe pas de consensus parmi les scientifiques qui le composent. »;

- « Il y a eu plusieurs documents de travail qui ont été présentés, pas de document de synthèse, explique un conseiller du chef de l’Etat. On ne peut donc pas considérer qu’une étude fournie par l’un de ses membres reflète l’avis du conseil scientifique dans son ensemble. »;

- « les chiffres évoqués [de 300 000 à 500 000 morts en cas d’absence de mesures d’endiguement] sont infiniment supérieurs à ceux communiqués par le ministère de la santé, ils apparaissent disproportionnés »;

- « C’est toute la difficulté de cette stratégie, qui n’avait jusqu’à présent jamais été envisagée pour un virus circulant de façon globalisée, en raison de son coût économique et social.»

Théoricien

du NRE

Neil Ferguson a pris pour habitude de qualifier ses détracteurs de « théoriciens du complot ». Il n’est pourtant nul besoin d’invoquer un « complot » pour expliquer qu’un scientifique arrive à exploiter habilement les processus médiatico-politiques pour promouvoir sa carrière professionnelle. On pourrait par contre qualifier Ferguson d’habile théoricien du « nouveau risque épidémique » (NRE), et de charlatan.

Modèle SIR

https://konfedera.org/gestion-epidemies#modele-SIR

Le modèle mathématique SIR est le modèle épidémiologique de base. Les modèles mathématiques se distinguent par leur degré de complexité (nombre de variables & paramètres, types de relations), mais leurs principes fondamentaux sont généralement identiques, et sont les plus visibles/compréhensibles dans les modèles les plus simples.

Système d’équations

Le modèle de base de la plupart des modèles épidémiologiques est appelé SIR [source1, source2]. Il sépare la population en trois groupes, des individus du premier passant progressivement au second puis au troisième : « Susceptible » (c-à-d contaminables) ⇒ « Infected » (c-à-d infectés) ⇒ « Removed » (c-à-d retirés, le terme « résistants » est aussi utilisé en français). Pour éviter certaines confusions de notation nous allons ici remplacer le nom « Removed » par « Excluded » (exclus).

Ce dernier groupe – qui en raison de la sous-estimation de certaines de ses composantes, joue un rôle majeur dans la nature catastrophiste des modèles épidémiologiques – comprend :

- les immunisés :

- de naissance;

- par vaccin;

- par immunité croisée.

- les guéris :

- naturellement;

- par traitement en médecine de ville;

- par traitement en milieux hospitalier (cas sévères).

- le décédés par le virus (et qu’il s’agira de distinguer des personnes décédées « avec le virus » mais pour d’autres raisons).

N.B. Cette version basique du modèle suppose donc que les personnes guéries sont immunisées. Il n’est pas ici nécessaire de lever cette hypothèse, car nous verrons que l’augmentation du nombre de variables ne change rien à l’incapacité des modèles épidémiologiques à reproduire la réalité autrement qu’en adaptant à chaque fois la valeur de leurs paramètres.

Mathématiquement la relation entre ces trois groupe est :

St + It + Et = 1(1)

En dérivant (1) par rapport au temps on obtient :

dS/dt + dI/dt + dE/dt = 0(2)

On peut alors décrire la dynamique des flux S –> I –> E au moyen d’un système d’équations différentielles tel que :

dS/dt = – β * It * St(3)

dI/dt = β * It * St – It / λ(4)

dE/dt = It / λ(5)

Lecture : durant la période dt, le flux net de I (c-à-d dI) est égal (au signe près) au flux sortant de S (dS) moins le flux rentrant dans E (dE).

Description des paramètres :

- β (bêta) : alors que le produit It * St est une mesure de la probabilité de contact entre un susceptible et un infecté, β est une mesure de la probabilité de contamination du premier par le second, et est (abusivement) dénommé « incidence »;N.B. β est supposé constant dans le temps. Nous verrons cependant que ce paramètre, en raison de sa variabilité et difficulté de mesure, constitue (avec la valeur initiale E0), l’une des principales causes de l’incapacité des modèles épidémiologiques à prédire le développement d’une épidémie.

- λ (lambda) est la durée moyenne de contagiosité = maladie = guérison (NB : cette égalité est une simplification de la réalité) ; plus λ est bas plus il y a de guérisons par unité de temps : à la limite λ = dt ⇒ dE = I ; 1 / λ est donc considéré comme le coefficient le plus simple pour exprimer dE/dt en fonction de de It ; dans la mesure où les individus guéris sont immunisés 1/λ est donc le « taux d’immunisation » ;

Hypothèses

Il faut bien comprendre que β et λ ne sont que des objets mathématiques, dont la pertinence en tant que représentation des phénomènes physiques qu’ils modélisent (incidence épidémique d’un virus ou d’une bactérie, et durée de maladie/contagiosité) n’est fondée que si les valeurs de ces paramètres, ou leur moyenne, sont constantes dans le temps et l’espace. C’est cette constance spatio-temporelle de la valeur des paramètres qui lie leur objet mathématique au phénomène physique modélisé. Si la stabilité spatio-temporelle des paramètres n’est pas observée alors on ne peut affirmer que le modèle représente la réalité. Il ne pourra ainsi éventuellement « reproduire » par le calcul les différences instances épidémiques d’un virus ou d’une bactérie (c-à-d dessiner la courbe avec les valeurs correctes du sommet épidémique, de sa date, et de la largeur moyenne de la courbe en cloche) que par l’adaptation de la valeur des paramètres. Dans ces conditions il est évidemment impossible que le modèle puisse prédire l’évolution d’une épidémie.

N.B. Cette problématique de stabilité spatio-temporelle ne doit pas être confondue avec celle des biais de mesure des paramètres (que nous traiterons dans la section #mesure-des-variables).

On notera ainsi le gigantesque raccourci que représente le modèle SIR, en résumant en trois lignes d’équations différentielles des phénomènes d’écosystèmes complexes, englobant les problématiques :

- épidémiologiques : propagation d’un virus;

- infectiologiques : contamination d’individus;

- médicales :

- développement éventuel de symptômes sévères (c-à-d nécessitant un traitement médical);

- traitements médicaux :

- symptomatiques;

- curatifs (ou préventif dans le cas de la vaccination);

Taux de reproduction

https://konfedera.org/gestion-epidemies#SIR-taux-reproduction

À partir de l’équation dI/dt = β * It * St – It / λ (4) on montre que :

- il y a croissance du nombre d’infectés dès que (tant que) :

dI/dt > 0 ⇔

β * It * St – It / λ > 0 ⇔β * St * λ > 1(6)

Le membre de gauche de (6) est supposé représenter le nombre moyen de personnes contaminées par individu infecté (*), et est par conséquent appelé « taux de reproduction » (noté Rt) :Rt = β * St * λ(7)

(*) Ce qui est inexact : il ressort de dI/dt = β * It * St – It / λ (4) que le nombre moyen de personnes contaminées par individu infecté c-à-d dI / I * λ = ( β * St * λ – 1 ) * dt.

Un épidémie est donc neutralisée dès que Rt < 1.

Le tableau ci-dessous est une réalisation graphique du modèle. On y voit notamment que la valeur de Rt (courbe hachurée orange, échelle de droite) baisse au fur et à mesure de l’épidémie, et que le sommet de la courbe rouge (infectés) correspond au passage de Rt en-dessous de 1. La baisse théorique continue de Rt s’explique évidemment par sa relation positive avec St, qui diminue tout au long de l’épidémie : Rt = β * St * λ(7).

Nous parlons de baisse théorique de Rt car le modèle SIR repose du l’hypothèse que la valeur moyenne de β et λ serait stable dans le temps et l’espace. Dans la section #R-zero-valeur-scientifique nous verrons (i) que cette hypothèse n’est généralement pas vérifiée, ce qui explique qu’en matière de prévisions les modèles épidémiologiques ne peuvent faire mieux qu’un tirage au sort parmi des résultats possibles, et (ii) que les paramétreurs des modèles épidémiologiques ont en outre une forte propension à exagérer la valeur de ces paramètres.

Tableur SIR.ods

Le modèle SIR montre donc bien que le taux de reproduction (Rt) diminue de toute façon c-à-d même sans politique de distanciation sociale (à supposer que celle-ci soit efficace …). Les entreprises « d’information » et leur conseillers scientifiques vous ont-il informé de ce fait ? Non, il vous ont plutôt asséné, jour après jour, que la baisse de Rt était due aux mesures de distanciations sociales, alors que toutes les pandémies de virus « nouveaux » depuis au moins la seconde guerre mondiale ont été gérées avec succès sans ces mesures autoritaires.

Immunité collective

https://konfedera.org/gestion-epidemies#SIR-immunite-collective

Le concept théorique d’immunité collective permet d’expliquer pourquoi les épidémies s’éteignent naturellement avant d’avoir contaminé 100% de la population.

Face à n’importe quel virus il y a toujours une partie de la population qui est immunisée : de naissance, par vaccin, par immunité croisée ou par guérison immunisante. Tous ces individus sont repris dans le groupe Et, avec E0 composé des personnes qui en t=0 sont immunisées de naissance, par vaccin ou par immunité croisée.

À partir de St + It + Et = 1 (1) ⇔

St = 1 – It – Et ⇒

substitué dans β * St * λ > 1 (6) ⇒

β * ( 1 – It – Et ) * λ > 1 ⇔

Et > 1 – It – 1 / ( β * λ )

L’épidémie est donc neutralisée dès que Et – c-à-d la part de la population qui est immunisée (ou décédée par le virus) – est supérieure à E*t (« E étoile ») qui est tel que :

E*t = 1 – It – 1 / ( β * λ )(8)

C’est pourquoi E*t est appelé « taux d’immunité collective« .

Et en particulier l’épidémie ne pourra pas même démarrer – c-à-d I0 = 0 – si Et est supérieur à :

E*0 = 1 – 1 / ( β * λ )(9)

Autrement dit, si une épidémie s’est déclenchée c’est nécessairement « parce que » Et était inférieur à E*0.

Taux d’immunité collective

La courbe bleue (E*t) n’est rien d’autre qu’une symétrie de la courbe rouge (It)

β=0,60 ; λ=15 [tableur]

On peut également exprimer E*t en fonction des variables plutôt que des paramètres : en substituant Rt = β * St * λ (7) ⇔ 1 / ( β * λ ) = St / Rt dans E*t = 1 – It – 1 / ( λ * β ) (8) ⇒

E*t = 1 – It – St / Rt(10)

de sorte que :

E*0 = 1 – S0 / R0(11)

Mécanisme

Il découle de It = 1 – St – Et (1) une modélisation probabiliste de l’extinction naturelle de toute épidémie (courbe en cloche) avant contamination (et potentielle extermination) de 100% de la population : la valeur de E*t détermine un seuil au-delà duquel la probabilité de propagation du virus est trop faible relativement au nombre de susceptibles St c-à-d de potentiels vecteurs de transfert.

Plus précisément, selon les modèles épidémiologiques, les facteurs explicatifs de l’extinction naturelle des épidémies sont de deux types :

- la baisse des flux entrant dans It : dS/dt de dI/dt = β * It * St – It / λ (4) ;

- la hausse des flux sortant de It : dE/dt de dI/dt = β * It * St – It / λ (4).

La forte propension des modèles épidémiologiques (ou faut-il parler plutôt de leurs paramétreurs ?) à produire des prévisions qui s’avèrent ex post de gigantesques surestimations du taux de mortalité des épidémies (cf. Neil Ferguson) peut s’expliquer notamment par la sur-estimation du taux d’immunité collective E*t = 1 – It – 1 / ( β * λ ) (8) via :

- au niveau des variables (dont valeurs initiales) : la sous-estimation de It et de E0 ;

- au niveau des paramètres : la surestimation de β (virulence) ou de λ (durée d’infection/contagiosité), donc la sous-estimation (en cours d’épidémie) du nombre de personnes immunisées par guérison.;

Parmi les causes de surestimation du risque épidémique, outre les manipulations des épidémiologistes charlatans (cf. infra la section #scientifiques-de-plateaux-TV), il y a aussi la sous-estimation de l’immunité collective (via E0 dans le paramétrage des modèles épidémiologiques). L’animation suivante montre qu’une sous-estimation de E0 (ici courbe verte démarrant à 0% vs 40%) se traduit par une surestimation du sommet de la courbe des infections (en rouge, 70% vs 30%). À noter qu’en raison notamment de l’immunité de naissance et de l’immunité croisée ce phénomène de sous-estimation de E0 joue même en cas de virus « nouveaux ».

Effet de la sous-estimation de E0

NB : ces paramétrages sont arbitraires.

Tableur SIR.ods

Autres causes. Nous verrons plus loin que l’incapacité des modèles épidémiologiques à prédire le développement d’une épidémie (sauf effet du hasard), et en particulier leur propension à surestimer le risque épidémique (où s’agit-il d’une propension des paramétreurs ?), peut avoir des causes exogènes. Parmi ces causes il y a très probablement la non prise en compte de facteurs opérant en amont du phénomène épidémique, et spécifiques aux virus ou aux écosystèmes (le modèle est alors dit « incomplet »). Autrement dit le concept de taux d’immunité collective ne permet pas d’expliquer pourquoi, sans politique de distanciation sociale, les épidémies s’éteignent généralement avant d’avoir atteint le taux d’immunité collective.

Stratégies

https://konfedera.org/gestion-epidemies#SIR-strategies

Nous avons vu supra que la décroissance du nombre de contaminés (seconde partie de la courbe en cloche) correspond à une situation telle que Rt = β * St * λ < 1 (7), et que par conséquent l’on peut théoriquement neutraliser une épidémie en abaissant tout ou partie des paramètres β et λ. Pour ce faire on peut distinguer deux types possibles de stratégie :

- non pharmaceutique (notée SNP) : qui est préventive, ancienne et fortement contraignante;

- pharmaceutique (notée SP) : qui est curative (donc réactive, sauf pour ce qui concerne les vaccins), moderne et faiblement contraignante.

SNP

Il s’agit d’abaisser la valeur du paramètre β (probabilité ≈ vitesse de contamination) par des mesures de distanciation sociale (isolement et hygiène). L’animation suivante compare les courbes épidémiques « sans SNP » (β=0,6 ; λ=15) et « avec SNP » (β=0,2 ; λ=15).

β = 0,6 –> 0,2 [tableur].

La stratégie SNP peut être appliquée à au moins deux niveaux d’intensité, selon que son application est générale (c-à-d sur l’ensemble de la population : confinement général) ou ciblée (c-à-d sur les seuls groupes à risque).

SP

Il s’agit (i) d’abaisser le paramètre λ (durée de la maladie=contagion) et d’augmenter la variable Et (comprenant les guéris) au moyen de médicaments (traitement), et (ii) d’augmenter la valeur initiale E0 au moyen de vaccins (prévention). L’animation suivante compare les courbes épidémiques « sans SP » (β=0,6 ; λ=15) et « avec SP » (β=0,6 ; λ=5).

λ = 15 –> 5 [tableur].

Comparaison

Les deux stratégies abaissent le sommet de la courbe épidémique (de 68% à 32%), ainsi que le niveau d’immunité collective neutralisante (de 89% à 67%). La stratégie SNP a en outre pour effet de retarder le pic épidémique (du 30° au 100° jour).

N.B. Ces chiffres sont fonction des valeurs attribuées aux paramètres. Ils n’ont donc pas ici de signification absolue.

Mais corrélativement le confinement général freine l’immunisation collective : dans la simulation du graphique suivant, alors que vers le quarantième jour 50% de la population a été immunisée naturellement, mois de 1% de la population est immunisée si l’on a appliqué plutôt la SNP, et il faut alors attendre jusqu’au début du cinquième mois pour atteindre les 50%.

Immunisation

Référentiel : β=0,60 ; λ=15

SNP : β=0,20 ; λ=15

SP : β=0,60 ; λ=5

[tableur SIR.ods]

Étant donné que le confinement général freine l’immunisation collective, il résulte de E*t = 1 – It – St / Rt (10) que, corrélativement, le taux de reproduction baisse nettement moins vite que dans le cas d’une stratégie SP.

Taux de reproduction

Référentiel : β=0,60 ; λ=15

SNP : β=0,20 ; λ=15

SP : β=0,60 ; λ=5

[tableur SIR.ods]

Mortalité

https://konfedera.org/gestion-epidemies#SIR-mortalite

On constante à la vue des équations (3) à (5) que le modèle SIR ne traite pas le taux de mortalité. Nous proposons donc ici une définition et un mode d’évaluation de cette statistique essentielle pour toute politique de gestion des épidémies.

Le taux de mortalité Mt = Σ ΔMt / Popul. = Σ ΔMt(12)

- Popul. = 1 en vertu de St + It + Et = 1 (1) ; les variables sont ainsi dites « normalisées« ;

Mortalité

β=0,60 ; λ=9 ; μ=0,2% [tableur SIR.ods]

Une valeur théorique de ΔMt et donc de Mt peut être calculée en évaluant le paramètre μ représentant le ratio du nombre de décès journaliers par rapport au nombre de nouvelles infections :

ΔMt = μ Δ+It (13)

Pour ce faire on calcule à la date n la moyenne μ = 1/n * ∑t=0n μt = 1/n * ∑t=0n ΔMt / Δ+It

De sorte que :

Mt ≈ ∑t=0n ΔMt = μ * ∑t=0n Δ+It(14)

On pourra également calculer un taux de létalité (Lt), défini comme le nombre de morts par rapport au nombre total de personnes étant ou ayant été infectées :

Lt = ∑t=0n ΔMt / ∑t=0n Δ+It = Mt / ∑t=0n Δ+It(15)

Dont la valeur théorique est μ étant donné (14).

Le taux de létalité n’est donc rien d’autre que le taux de mortalité divisé par le taux d’infection totale (c-à-d y compris les personnes ayant été infectées et qui ne le sont plus). Il est donc plus élevé que le taux de mortalité puisque le taux d’infection qui le divise est inférieur à un. Ou, pour dire les choses plus simplement : comparer le nombre de morts à la seule population des infecté donne évidemment un taux plus élevé que si l’on compare le nombre de morts à l’ensemble de la population.

N.B. La moyenne μ, et partant les définitions (14) et (15), n’ont d’utilité que si μ est stable dans le temps (entre épidémies d’un « même » virus), et dans l’espace (entre différentes régions durant une épidémie). Or nous verrons que cette condition n’est généralement pas vérifiée en raison de la nature écosystémique, et donc complexe, des phénomènes infectiologiques !

Résultat

Étant donné la formulation du taux de mortalité en fonction de It la courbe de mortalité suit l’évolution de la courbe épidémique (sauf qu’ici il y a accumulation ⇒ pas de courbe en cloche).

Taux de mortalités théoriques selon la stratégie

Référentiel : β=0,60 ; λ=9

SNP : β=0,20 ; λ=9

SP : β=0,60 ; λ=3

∀ : μ=0,002 (décès journaliers / nouvelles infections )

Tableur : SIR.ods

Le lecteur pourra vérifier dans le tableur que :

- si on abaisse la valeur de β les courbes s’abaissent et sont retardées;

- si on abaisse la valeur de λ dans une même proportion on observe le même phénomène sauf que l’effet retard est plus faible.

Cependant il est peu probable que les deux stratégies soient également efficaces (SIR.ods > feuille « Synthèse » > lignes 2 et 3 : xβ = xλ). Nous verrons dans la section #efficacite-strategie-non-pharma de nombreux faits suggérant que le taux d’efficacité de la stratégie SNP pourrait être inférieur à celui de la stratégie SNP (x β < xλ). Ainsi si xβ=2 pour xλ=3 alors l’effet retard de la stratégie SNP (distanciation sociale) passe de trois à un mois et, surtout, le taux de mortalité final est plus élevé que celui de la stratégie SP (traiter).

Hypothèse de faible efficacité relative de la stratégie SNP

Référentiel : β=0,60 ; λ=9

SNP : β=0,30 ; λ=9 ; xβ=2

SP : β=0,60 ; λ=3 ; xλ=3

∀ : μ=0,002 (décès journaliers / nouvelles infections )

Tableur : SIR.ods

Voilà probablement une des raisons expliquant la forte mortalité de covid-19 dans les pays ayant appliqué la stratégie SNP (cf. infra : #mortalite-differences-entre-pays). Nous verrons que l’effet de faible efficacité du confinement général (cf. infra : #efficacite-strategie-non-pharma) illustré ici est renforcé par ses effets pervers (cf. infra : #effets-pervers-strategie-non-pharma).

Charge hospitalière

https://konfedera.org/gestion-epidemies#SIR-charge-hospitaliere

On constante à la vue des équations (3) à (5) que le modèle SIR ne traite pas le taux d’hospitalisation. Nous proposons donc ici une définition et un mode d’évaluation de cette statistique essentielle pour toute politique de gestion des épidémies.

Selon notre définition le taux d’hospitalisation (noté Ht) est la valeur normalisée (en pourcentage de la population) du nombre journalier de lits occupés par les infectés sévères du virus (les autres pouvant rester à leur domicile). Une façon de le calculer consiste à ajouter à la charge hospitalière du jour précédent les entrants du jour, moins les sortants du jour (vivants ou décédés) :

Ht = Ht-1 + Δ+Ht – Δ–Ht(16)

où H1 = H0 = Δ+H0 de sorte que l’on peut calculer une valeur théorique de Ht par :

- Δ+Ht = σ * Δ+It(17)

où σ (« sigma ») est le pourcentage de personnes infectées nécessitant une hospitalisation ;

pour évaluer σ on calcule à la date n la moyenne σ = 1/n * ∑t=0n Δ+Ht / Δ+It - Δ–Ht = Δ+Ht-λ = σ * Δ+It-λ(18)

où λ (« lambda ») est la durée de contagiosité = maladie = guérison (NB : cette égalité est une simplification de la réalité) ⇔ le nombre de sortants est égal à celui des entrants d’il y a λ jours.

NB : dans les statistiques épidémiques publiées par les agences de santé les sorties d’hospitalisation concernent généralement les seules sortes en vie ⇒ il faut leur ajouter la part des décès en milieu hospitalier du jour pour obtenir le Δ–Ht de (18).

de sorte que :

Ht = Ht-1 + σ * Δ+It – σ * Δ+It-λ ⇔

Ht ≈ Ht-1 + σ * ( Δ+It – Δ+It-λ )(19)

Enfin la charge hospitalière (notée CHt) est :

CHt = Ht / k(20)où

- k, la capacité hospitalière, est mesurée par le taux de lits de soins intensifs c-à-d pour les cas sévères (patients sous respirateur, …) ou critiques (dysfonctionnement de multiples organes, choc septique, …) toutes causes confondues.

- N.B. La moyenne σ, et partant les équations (19) et (20), n’ont d’utilité que si σ est stable dans le temps (entre épidémies d’un « même » virus), et dans l’espace (entre différentes régions durant une épidémie). Or nous verrons que cette condition n’est généralement pas vérifiée en raison de la nature écosystémique, et donc complexe, des phénomènes infectiologiques !

- Alors que le taux de mortalité est de type Stock à flux entrant / Stock fixe (⇒ il augmente constamment puis se stabilise à sa valeur finale de l’épidémie), le taux de charge hospitalière est de type Stock à flux entrant et sortant / Stock fixe.

Résultat

Le graphique suivant montre un résultat notable du modèle SIR : la stratégie SNP (confinement général) a théoriquement pour effet de retarder le sommet de l’épidémie, et par conséquent celui de la charge hospitalière, nettement plus que la stratégie SP.

Charge hospitalière théorique selon la stratégie

Référentiel : β=0,60 ; λ=9

SNP : β=0,20 ; λ=9

SP : β=0,60 ; λ=3

∀ : μ=0,002 (décès journaliers / nouvelles infections )

∀ : σ=0,001 (taux d’hospitalisation)

∀ : k=0,003 (capacité hospitalière)

Tableur : SIR.ods

Même réflexion que pour le taux de mortalité : il est peu probable que les deux stratégies soient également efficaces (SIR.ods > feuille « Synthèse » > lignes 2 et 3 : xβ = xλ). Nous verrons dans la section #efficacite-strategie-non-pharma de nombreux faits suggérant que le taux d’efficacité de la stratégie SNP pourrait être inférieur à celui de la stratégie SNP (xβ < xλ).

Si l’efficacité de la stratégie SNP sur son paramètre β est relativement moins efficace que la stratégie SP sur son paramètre λ – par exemple xβ=2 pour xλ=3 – alors le graphique devient comme suit : SNP retarde toujours le sommet mais celui-ci est plus haut que si l’on applique plutôt la stratégie SP ! Si cela fait passer la charge hospitalière au-delà de la capacité on aura alors une nouvelle aggravation de la mortalité !

Hypothèse de faible efficacité relative de la stratégie SNP

Référentiel : β=0,60 ; λ=9

SNP : β=0,30 ; λ=9 ; xβ=2

SP : β=0,60 ; λ=3 ; xλ=3

∀ : μ=0,002 (décès journaliers / nouvelles infections )

∀ : σ=0,001 (taux d’hospitalisation)

∀ : k=0,003 (capacité hospitalière)

Tableur : SIR.ods

Voilà qui renforce la thèse selon laquelle la forte mortalité de covid-19 dans les pays ayant appliqué la stratégie SNP (cf. infra : #mortalite-differences-entre-pays) fut causée non pas par le virus mais par le confinement général. Nous verrons que l’effet de faible efficacité du confinement général (cf. infra : #efficacite-strategie-non-pharma) illustré ici est renforcé par ses effets pervers (cf. infra : confinement-effets-pervers).

On pourra à priori objecter que les deux stratégies SNP et SP pourraient être appliquées complémentairement, mais nous exposerons dans la section #effets-pervers-strategie-non-pharma leur très difficile compatibilité.

Valeur scientifique du « R zéro »

https://konfedera.org/gestion-epidemies#R-zero-valeur-scientifique

Nous allons ici montrer la nature trompeuse voire fallacieuse de cet objet mathématique cher aux épidémiologistes adeptes des modèles mathématiques.

Le fumigène R0

https://konfedera.org/gestion-epidemies#R-zero-enfumage

Dans la section #SIR-taux-reproduction nous avons vu que la valeur théorique du taux de reproduction (Rt) baisse toujours, quelle que soit la stratégie anti-épidémique appliquée, et même sans stratégie du tout ! La raison, mathématique, est sa relation positive avec St dans Rt = β * St * λ (7), or St diminue tout au long de l’épidémie ⇒ Rt aussi.

Taux de reproduction (valeurs fictives)

Évolution du taux de reproduction selon la stratégie : non pharmaceutique (SNP c-à-d confinements, masque & lavages) ou pharmaceutique (SP c-à-d traitement avec médicaments spécifiques ou non).

Or durant l’épidémie de covid-19 des conseillers scientifiques de nombreux gouvernements ont scandaleusement abusé l’opinion publique en affirmant que la baisse de Rt serait le résultat du confinement !

Ces scientifiques ne sont-il pas plutôt cautions que conseillers scientifiques ?

En Belgique, pays où le taux de mortalité lié à covid-19 est le plus élevé au monde, ce fut notamment le cas du très médiatisé Yves Coppieters, professeur à l’École de santé publique de l’université libre de Bruxelles. Dans cette cette « analyse prédictive » (sic) publiée le 10 avril 2020, Coppieters, constatant une baisse du paramètre β, affirme avec ses coauteurs que « le confinement résulte en une chute spectaculaire de la force d’infection du paramètre β, de 0,594 avant le confinement à 0,156 après confinement (…) » !

Incompétence ? Or le graphique suivant montre que déjà avant le confinement βt était dans une tendance baissière, et de plus grande ampleur ! Par conséquent la moyenne avant n’importe quelle date est évidemment supérieure à la moyenne calculée sur la période après cette date arbitraire ! Alors, selon vous, le Pr. Yves Coppieters et tous les épidémiologistes qui font ce genre de chose sont-il des incompétents ou des charlatans … ?

Beta avant et après le confinement (covid-19 Belgique)

Tableur covid19-be, feuille « J90 » > colonnes J et K

Les charlatans ne sont pas nécessairement des incompétents : c’est parfois même en raison de leurs compétences que certains peuvent « offrir » (sic) leurs services pour servir de « caution scientifique » (cf. #scientifiques-de-plateaux-TV).

De nombreux scientifiques sont abusés par cet écran de fumée cognitif qu’est le très médiatisé « taux de reproduction de base » ou « R zéro« . Le lecteur attentif se demandera quelle est la différence entre le taux de reproduction en t=0 R0 = β * S0 * λ (7) et le taux de reproduction « de base ». La réponse – hautement ambiguë lorsque l’on utilise la notation R0 plutôt que de dire « taux de base« , et R0 plutôt que de dire « taux initial » – est que le taux de base est un type de valeur moyenne (*) des Rt (donc valeurs de βt et λt), calculée sur la période précédant une date arbitraire et de durée arbitraire …

(*) Il existe divers types de moyenne : arithmétique, géométrique, harmonique, quadratique [source] …

Calcul du R0

https://konfedera.org/gestion-epidemies#R-zero-calcul

Voici comment le concept de « R zéro » est mathématiquement construit. Partant de dI/dt = β * It * St – It / λ (4) ⇔ It+1 = It + ( β * It ) * St – It / λ on va exprimer βt en fonction du taux de croissance des It :

soit it+1 = ( It+1 – It ) / It ⇒

it+1 = βt * St – 1 / λ ⇔

βt = ( it+1 + 1 / λ ) / St(21)

que l’on substitue dans Rt = βt * St * λ (7) ⇒ :

Rt = it+1 * λ + 1(22)

Or on peut montrer [approfondir] que le taux croissance moyen d’une variable It entre t=0 et t=n peut être calculé par la formule :

i = ln( It / I0 ) / t ⇔(23)

It = I0 * e i * t(24)

où (24) est l’équation d’une courbe (exponentielle) moyenne qui représentera d’autant mieux le nuage des points constitués par la série réelle des It que celui-ci sera proche d’une exponentielle.

Courbe de régression

Δ+It : période pré-confinement en Belgique.

[Tableur covid19-be.ods > feuille « Data »].

Dès lors – pour en revenir au modèle SIR – en remplaçant it par i dans (22) on obtient le taux de reproduction de base :

R0 ≈ i * λ + 1(25)

De même dans βt = ( it+1 + 1 / λ ) / St (21) on pourra également remplacer it par i ⇒ si St est proche de 1 (ce qui est le cas durant les premières semaines d’une épidémie, voire même durant toute l’épidémie lorsque celle-ci ne touche qu’une petite partie de la population) on obtient la valeur correspondante de beta (correspondant à cette période) :

β0 ≈ R0 / λ(26)

Alors que le taux de reproduction initial R0 fait sens (du moins en tant qu’objet mathématique), le taux de reproduction de base R0, en tant que moyenne est une absurdité : c’est une moyenne « gloubi-boulga », que de nombreux épidémiologistes évoquent par suivisme, sans comprendre vraiment de quoi ils parlent.

Ceci dit, malgré l’égalité β0 ≈ R0 / λ (26), β conserve sa pertinence … du moins théorique car en pratique la stabilité spatio-temporelle de sa valeur, même en temps que moyenne, est illusoire.

Utilisations du R0

https://konfedera.org/gestion-epidemies#R-zero-utilisations

Nous venons de montrer que la notion de R0 ne fait pas sens. Mais supposons maintenant que ce n’est qu’une autre façon d’écrire R0 ⇔ le taux de reproduction de base c’est le taux de reproduction initial. Nous allons voir que même dans ce cas le concept de R zéro n’a quasiment aucune utilité.

Comparaisons

spatiales ?

Théoriquement ce R0 pourrait être utilisé pour comparer la situation de différents pays dans le cas d’une même épidémie. Cependant en pratique, la pertinence de R0 comme référentiel de comparaison est illusoire pour deux raisons :

- d’une part il faut pouvoir garantir que la date initiale (le zéro) correspond au même stade de développement de l’épidémie dans chaque pays, ce qui requiert de définir de façon non ambiguë ce qu’est est un « même stade de développement d’une épidémie », et de pouvoir le mesurer avec une marge d’erreur pas trop grande … ;Par exemple ce que l’on considère comme le début des premiers décès liés à tel virus est en réalité le moment à partir duquel on a commencé à attribuer (à tort ou à raison) des décès à ce virus, ce qui très différent.

- d’autre part il faut tenir compte de la structure sociale et démographique des pays, car les maladies transmissibles sont des phénomènes d’écosystème.

Comparaisons

temporelles ?

On pourrait également utiliser R0 pour comparer les épidémies saisonnières d’un virus connu … ce qui revient à reconnaître l’instabilité temporelle des paramètres β et λ, et par conséquent l’incapacité des modèles épidémiques à prédire l’évolution d’une épidémie d’un virus « connu ». Les épidémiologistes adeptes des modèles mathématiques sont décidément des contorsionnistes du concept …

« Prévisions »